Formation en Large Language Models (LLM)

RAG - Agents - Fine-tuning

A qui s'adresse cette formation ?

Cette formation s'adresse à des profils techniques : data scientists, ML engineers, développeurs, etc. Elle s'adresse plus généralement aux personnes qui veulent acquérir des connaissances techniques avancées sur les LLM et leurs applications.

Prérequis

Connaissances en programmation, notamment en Python.

Objectifs pédagogiques :

À l'issue de la formation, les participants seront capables de :

-

Comprendre l'architecture et le fonctionnement des LLM

-

Maîtriser les applications des LLM (RAG, Agents, etc.)

-

Fine-tuner des LLM pour les adapter à des cas d'usage

-

Développer des applications avec LangChain

A propos de l'intervenant

Redha Moulla est formateur, consultant et enseignant en intelligence artificielle dans l'école d'ingénieurs EPITA.

-

15 ans d'expérience en IA

-

Plus de 800 professionnels formés

-

Plus de 60 entreprises accompagnées

-

Docteur en automatique et Masters en data science, physique et économie

Programme de la formation

Le programme de la formation alterne entre parties théoriques et mises en pratique sous Python et Pytorch.

Fondamentaux des LLMs

-

Eléments de deep learning

-

Représentations distribuées de mots (Embeddings)

-

Modèles classiques pour le NLP (RNN, LSTM, Seq2Seq)

-

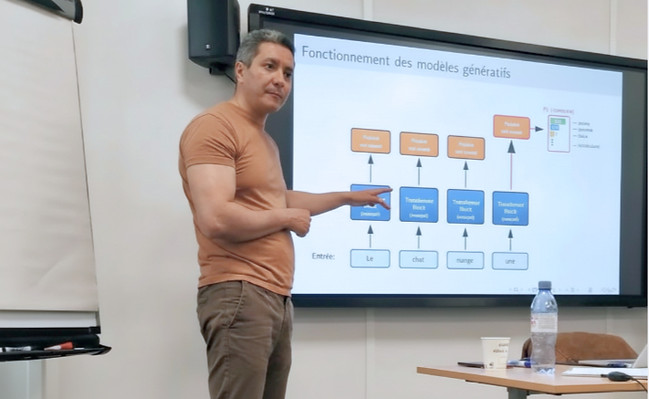

Mécanisme d'Attention et transformers

-

Tokénisation

-

Positional encoding

-

Modèles BERT

-

Modèles auto-régressifs (GPT)

-

Mise en pratique avec PyTorch : fine tuning d'un modèle BERT

Retrieval Augmented Generation (RAG)

-

Introduction aux RAG

-

Bases de données vectorielles

-

Modèles de similarité pour le retrieval (cross-encodeurs, ColBERT, etc.)

-

Reranking

-

Techniques avancées

-

Ecosystème LangChain

-

Mise en pratique avec LangChain : implémentation d'un RAG

Agents basés sur les LLMs

-

Principes d'un Agent LLM

-

Différence entre Agent et un workflow automatisé

-

Workflows avec n8n

-

Agents ReAct

-

Systèmes multi-agents

-

Protocole MCP

-

Mise en pratique : implémentation d'un Agent avec LangChain et MCP

Fine-tuning des LLMs

-

Supervised fine-tuning

-

RLHF

-

Parameter efficient fine-tuning (PEFT)

-

LoRA

-

Modèles de raisonnement

-

GRPO

-

Mise en pratique sous Pytorch : Fine tuning d'un LLM open source